Amalgama

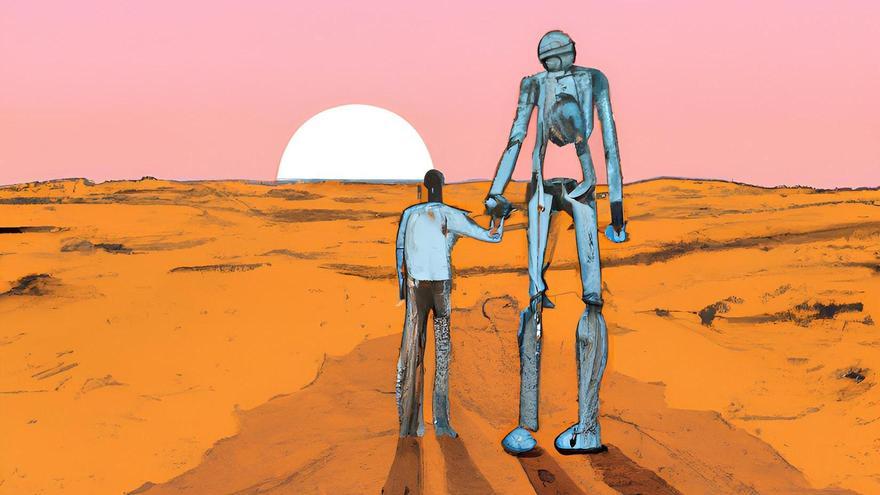

El loro estocástico despierta

El loro estocástico despierta / La Provincia

Todos los que utilizamos el Modelo de Lenguaje OpenAI, nos hemos acostumbrado, abatido el principio de Alan Turing, a hablar con la máquina, aunque nos diga tonterías e incertezas, pues eso ya lo dice cualquier persona. Cuestión solo de información veraz, no de inteligencia. Discutí con el ingeniero Felipe Gómez-Pallete y la jurista Paz de Torres, en un encuentro sobre Inteligencia Artificial en la Asociación Torrelavega de Lanzarote, cuando mentamos la AGI, es decir, la Inteligencia Artificial Generativa, lo que es como aludir al mismísimo diablo para que nos convierta a los humanos en una raza inferior en el flujo vital y estructural de las sociedades humanas, posthumanas y transhumanas. Afirmaba en ese foro Paz de Torres que, a día de hoy, puede calcularse que más del 60 por cien de los algoritmos de Inteligencia Artificial los está creando la máquina (se le denomina Machine Learning a usar los algoritmos para analizar y aprender de los datos, y Deep Learning a ordenar los algoritmos por capas, clonando las redes neuronales, y pretendiéndose que la IA tome decisiones por sí misma), o sea, que ya la inteligencia generada no es de origen propiamente humano.

Y aquí viene el lío, un lío ya advertido filosóficamente hace unos pocos años por Nick Bostrom, cuando en Superinteligencia, texto publicado en 2014, consideraba que llegaría un momento en el que la forma de pensar, las formas cognitivas de la Inteligencia Artificial, se desarrollarían en un nivel incomprensible para el humano, con unas reglas lógicas distintas a las que manejamos hoy día y dominadas por probabilidades bayesianas, de forma que los superordenadores hablarían entre sí en lenguajes imposibles de traducir al humano. Y he aquí que llega hace un par de semanas el despido urgente de Sam Altman, fundador de OpenAI, y se atribuye el mismo a haber revelado que OpenAI maneja un nuevo modelo de algoritmo, llamado Q* (se designa como Q star), que ya funciona como una AGI, es decir, como una Inteligencia Artificial Generativa, que, aunque esté empezando a resolver meros problemas matemáticos básicos, lo hace ya autónomamente, sin que se le den previamente programas y órdenes (en The Information dicen que quien lideró ese proyecto fue Ilya Sutskever, director científico en OpenAI). Es el famoso y terrible y temible paso que hemos negado que pueda existir o ser posible. Pues bien, Altman fue inmediatamente despedido, aunque posteriormente lo han readmitido porque Microsoft, que no tiene deferencias éticas al respecto, lo iba a contratar para el desarrollo de su propia IA, aunque ya Microsoft es partícipe fundacional en la organización OpenAI.

Esta información, de la revista The Verge, en base a informes de Reuters, ha sido negada por la compañía, pero todas las alarmas ya han saltado. Alex Heath, en The Verge, explica: «a mí me parece que la implicación debe ser que resolvió problemas matemáticos sencillos sin tener que entrenarse primero en ellos como necesitan otros Modelos de Lenguaje. Lo que significaría que demostró la capacidad de aprender y resolver problemas de forma autónoma... resolver estos problemas sin el entrenamiento previo». En un ejemplo muy gráfico e irónico de Heath: «El coche nunca sustituirá al caballo. Las calles son demasiado irregulares, los neumáticos son demasiado frágiles, la velocidad máxima es de sólo 10 mph y son propensos a fallar. Hay que replantearse el automóvil desde cero. Deberíamos tirar a la basura lo que tenemos, empezar de cero y hacer que se parezca más a un caballo. AGI se parece más a una nave espacial. Por mucho que iteremos sobre un coche, no nos llevará a la luna».

En los Modelos de Lenguaje se denomina «loros estocásticos» a los modelos que son buenos generando textos, pero que no entienden el significado del texto que están procesando, capaces de escribir grandes ensayos con una estructura racional, pero cuyos datos y supuestos son falsos o inventados. Este problema se arreglaría con Q star.

Con la IA actual, ya ocurren desastres en su aplicación; por ejemplo, en 2011, el gobernador de Michigan autorizó que la Agencia del Seguro de Desempleo de Michigan desarrollara un nuevo algoritmo para detectar el fraude, lo cual se implementó en 2013, y el programa, denominado MiDAS, acusó falsamente de fraude a más de 40.000 personas, sancionándolos gravemente. Se arregló, pero las bases de datos pasaron a otras instituciones con las falsedades incluidas, y miles de personas quedaron sin cobrar paro y apartadas del mercado de trabajo. Los damnificados judicializaron el tema y les dieron la razón en 2022, nueve años después. La directora de la red de comunicación Signal y presidenta de la ONG AI Now, Meredith Whittaker, denominó «dobles de datos» a estas réplicas falsas de personas que corren por internet, que se reempaquetan y revenden y son casi imposibles de eliminar: «Estos sistemas generan datos personales falsos que nadie les ha dado, y se convierten en más reales que la verdad» (Annalee Newitz, abril 2023, en Esquire).

Cuando una IA simplona, no generativa, muy lejos del Machine Learning, que ya dirige los coches eléctricos, la red de energía, los flujos del tráfico, los puentes, los controles de climatización de un edificio, etcétera, por no hablar de las armas autónomas de todo tipo, se convierta en AGI, o sea, en Inteligencia Artificial autónoma, fuera de la voluntad humana ¿Qué va a pasar? Estamos ya llegando ahí.

- Malas noticias para los turistas: la UE crea un nuevo documento obligatorio para viajar

- Buenas noticias para los amantes de la limpieza: crean un cubo para tener el agua siempre limpia

- José Alberto Medina, dueño de Fábrica La Isleta, condenado dos veces por violencia machista

- El escondite de Miguel Ángel Silvestre en Gran Canaria: esta es su playa favorita

- Salvan la vida a una menor durante el UD Las Palmas - Betis

- Los pronósticos de Esperanza Gracia para la semana del 18 al 24 de mayo, signo a signo

- Juan Antonio Ballesta, militar: «Tenemos los medios necesarios para que las Islas estén seguras»

- Sara Rodríguez (Airbnb): «La actividad del alquiler vacacional no es responsable del turismo masivo»